Förkortningen AI började spridas som en löpeld hösten 2022. Men det berodde inte på att något genomgripande tekniskt framsteg plötsligt skett gällande data- och signalbehandling. Det berodde på att den pågående utvecklingen med snabbare processorer och massiva datamängder kombinerades med ett användargränssnitt som med några trick fick användarna att känna att det nu fanns ”intelligens bakom”. Till tricken hörde bland annat att systemen broderade ut sina svar med lite extra ”pratighet”, eller levererade svaren som om en riktig person knapprade in text i en chat – eller svarade med talsyntes.

Det är inte första gången datavärlden upplever en ”AI-boom”. Den första större boomen skedde i slutet av 1980-talet, då utvecklingen gått så långt att vem som helst kunde köpa en (på den tiden) kraftfull persondator. Även då liknade marknadsutvecklingen den som sker idag, det vill säga snart sagt allting som gällde databehandling fick en ”AI”-stämpel på sig. Men då hyperbolen småningom ebbade ut, försvann begreppet ur allmänt bruk i flera årtionden.

Varför började alla då tala om AI hösten 2022, även i de fall databehandlingen alltså inte just alls hade något med riktig intelligens att göra – vare sig mänsklig eller artificiell? Den banalaste förklaringen är att dataföretagen i jakt på omsättning älskar förkortningar, och älskar att piska upp hyperbol – både gällande guld och gröna skogar samt hotbilder. Men diskussionen har också en annan dimension, som tyvärr riskerar att drunkna i hyperbolen: alldeles legitima frågor om personlig integritet och personlig frihet – grundpelare i våra västerländska samhällen – där både myndigheter, kommersiella intressen och kriminella lätt och behändigt kan inskränka på friheterna med den nya, massiva databehandlingen. Och helt oberoende om vi kallar denna databehandling ”AI”, eller något annat.

Inget nytt begrepp

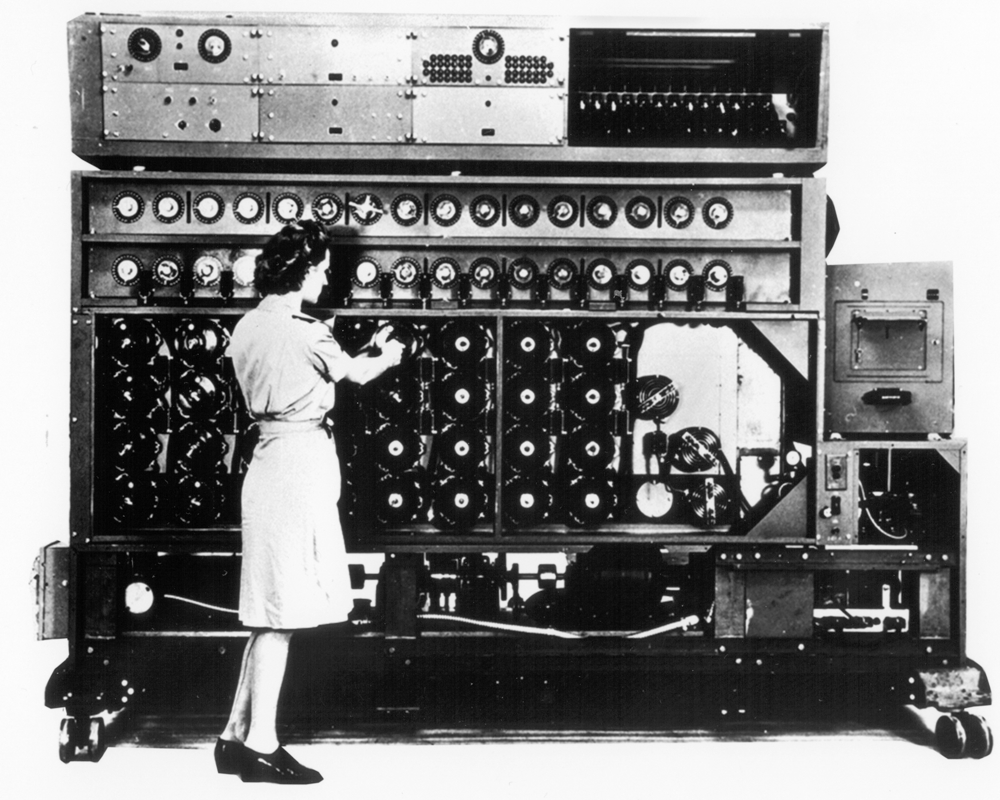

AI, eller Artificiell Intelligens, är alltså inget nytt begrepp. Det myntades genast efter andra världskriget, ett krig som starkt accelererade både mekanisk och elektronisk databehandling. Under kriget var syftet att knäcka krypterad militär kommunikation och göra ballistiska uträkningar.

Men det tog inte länge innan forskarna i kölvattnet av de allt snabbare och kraftfullare ”elektroniska hjärnorna” började se framför sig en framtid där datorerna eventuellt kunde nå en intelligens som matchade, eller till och med överträffade den mänskliga. Ett läge där en maskin, liksom människan, kunde ”lära sig att lära sig själv”.

Idag kallas detta hägrande slutmål för AGI, eller Artificial General Intelligence. Men framstegen har i alla dessa år varit små och stapplande, eftersom man de facto ännu vet ganska lite om hur mänsklig intelligens fungerar. Så även om det är frestande att tro att hjärnan fungerar lite som en dator, och att vi därför omvänt kan få datorer att fungera som hjärnor, är det betydligt sannolikare att hjärnan arbetar på ett fundamentalt annorlunda sätt. Det är också troligt att det behövs mycket mer än bara en ”dataprocessor” för intelligens, till exempel en kropp som sätter yttre gränser mot verkligheten, känslor som hänger ihop med vår överlevnadsinstinkt, och ett medvetande som emanerar från allt detta. Kan sådant ens programmeras på en hög av metall och plast? Till de här frågorna återkommer jag i en annan artikel.

Vid sidan av de processorer vi hittar i våra egna persondatorer eller telefoner arbetar de stora processortillverkarna idag även med experimentella processorer, där idén är att bättre emulera människans hjärnfunktioner. Tanken är att även om vi inte exakt vet hur mänsklig intelligens på riktigt fungerar, kan vi kanske ändå en vacker dag skapa en syntetisk ”hjärnliknande” intelligens, genom att bygga en så exakt kopia som möjligt av hjärnans elektrokemiska process- och minnesfunktion. En tillräckligt snabb processor av den sorten kunde då i teorin även ”överträffa” mänsklig intelligens.

Från dessa experiment har vi inte hört särskilt mycket ännu. Under tiden kan vi fundera över hur interaktionen med en sådan maskin borde gå till, och vilken praktisk, konkret nytta vi kunde ha av en maskin, vars intelligens på något mätbart sätt skulle överskrida vår egen. Borde vi enbart begränsa oss till att ställa denna ”intelligens” existentiella och filosofiska frågor? Ingenjörsproblem kan vi ju redan lösa enkelt med alldeles vanliga datorer.

Hot och dystopier

Med AGI målar man idag liksom på 1980-talet upp de värsta hoten med AI, det vill säga en dystopisk framtid där AI börjar bygga ut sig själv, tar över, och sedan börjar utrota människosläktet som något överlopps eller ekologiskt farligt. De här scenarierna hör förstås mer hemma i fantasifulla Hollywood-manus än i verkligheten – inga maskiner fungerar nämligen utan energitillförsel, och den är enkel att stänga av innan det hela skenat iväg för långt.

Men visst har utvecklingen gått framåt. Eftersom datorerna blivit betydligt snabbare och lagringskapaciteten ökat exponentiellt har det blivit möjligt att pålitligt emulera mänskliga kognitiva förmågor. Man kan idag med rätt stor precision träna datamaskiner att se och höra mönster (till exempel text eller bild), varefter programmen kan dra någorlunda korrekta slutsatser om materialet som getts dem, och leverera tillbaka resultat och slutsatser i intressanta kombinationer.

Problematik: Pålitlighet

Då ChatGPT lanserades 2022, med flera andra liknande system i kölvattnet, uppdagades rätt fort att någon riktig intelligens inte riktigt kunde hittas bakom kulissen. Systemen började nämligen fort hallucinera ihop ren smörja – trots att denna smörja lät auktoritativ och trovärdig. Det berodde på att språkmodeller som ChatGPT (large language models) är tränade på existerande data, och att algoritmerna med sannolikhetskalkyler avgör vilka ord som borde hänga ihop i de svar systemen ger. Ifall algoritmerna haltar, eller den data systemen tränats på är begränsad, icke-uppdaterad eller behäftad med fel, riskerar förstås även svaren att bli felaktiga och vilseledande. Och tränar man systemen, speciellt bildgeneratorerna, på bilder man hittar öppet på internet, återspeglar datan förstås hela mänskligheten, inklusive misshagliga fenomen som fördomar och rasism.

Efter klagomål och påpekanden har de flesta system sedan hösten 2022 blivit en aning bättre. De flesta har även kopplat in nätsök i resultaten, så att aktuella och faktuella delar av svaren bättre ska stämma överens med verkligheten. Här gäller förstås samma problematik gällande pålitlighet som alltid gällt vid nätsökningar.

Att systemen utvecklas och ständigt blir bättre på att leverera adekvata svar är säkert. Om svaren når en tillräckligt hög pålitlighetsnivå kan man förstås ställa den filosofiska frågan: spelar det för oss någon roll om det finns “riktig” intelligens bakom eller inte? Behöver vi ens tala om intelligens i sammanhanget, ifall det vi nu kallar ”AI” blir ett användbart verktyg i våra dagliga rutiner?

Problematik: Upphovsrätt

Eftersom de nya verktygen syntetiserar nytt material på basen av existerande material är en del upphovsrättsliga frågor, speciellt kring bilder, fortfarande outredda. Är det “AI:n” som skapat bilden, eller till exempel tillhandahållaren Microsoft? Eller är det du, eftersom du skrivit instruktionen (det som även kallas prompt)? Är det fråga om plagiat, ifall existerande verk skapade av människor kan kännas igen i AI-resultatet?

I USA väntar man nu på att några uppmärksammade rättegångar småningom ska skapa prejudikat. En del AI- leverantörer har tidigare meddelat att de tar på sig alla eventuella juridiska följder på användarnas vägnar, men ur upphovsrättslig synvinkel har de nya verktygen i sig inte ändrat på något gällande lagstiftning och kutym.

Som förr gäller att idéer inte kan vara föremål för upphovsrätt, endast det sätt en idé uttrycks – till exempel som en bild eller text. Då något man skapat uppfyller kriterierna för upphovsrätt kallas det verk. Den som skapat ett verk har alltid rätt att bestämma hur verket används eller distribueras. För detta behövs ingen deklaration, copyright-symbol eller ens att namnet sätts ut. Med avtal, till exempel med förläggare eller arbetsgivare, kan en del eller hela upphovsrätten överföras. Intressebevakning och licensering kan också överföras, till exempel på en upphovsrättsorganisation.

Om en AI-skapad bild ser ut som om en känd konstnär målat bilden, kan alltså konstnären inte hävda något – en “stil” är inte föremål för upphovsrätt. Men om ett redan skapat verk kan kännas igen (det kan förstås bli fråga om gradskillnader) blir det en upphovsrättsfråga. Och förstås även om någon (AI eller verklig person) påstår att den AI-genererade bilden faktiskt är skapad av en konstnär.

Om en text som AI skapat “låter bekant” är det inte automatiskt plagiat. Bara om AI skulle kopiera text “rakt av” utan sedvanlig citering (citaträtten finns kvar som förr) kan det bli fråga om plagiat.

Ifall man använder de allmänt tillgängliga systemen lönar det sig främst att ta reda på vilken status det material man själv laddar upp får. Ger man eventuellt avkall på sin egen upphovsrätt eller delar av den, ifall man laddar upp en artikel eller en text man skrivit, eller en bild man tagit? Används materialet man laddat upp automatiskt för att utveckla språkmodellen eller bildgeneratorn? Läs gärna det finstilta innan du klickar dig framåt. Som en generell rekommendation gäller att aldrig ladda upp känsligt personligt material eller affärshemligheter i systemen.

Problematik: re-generering och regression, fejkmaterial

Eftersom de generativa AI-systemen ännu är unga är det ännu outrett vad som händer då användarna matar tillbaka det som AI:n hjälpt dem skapa, och där detta nya material används för att träna systemen vidare, och generera nya resultat. Finns det risk för att eventuella fel och brister under några omgångar förstärks till den grad att det till sist krävs massiva mänskliga insatser för att rätta till felaktigheterna? Eller att fejkat material på kända personer: bilder, videon, fejkat ljud, småningom smyger in sig även i de resultat som betecknats som pålitliga?

Forskarna är fortfarande oense om hur stor denna risk är. För tillfället pågår ändå forskning kring eventuella motåtgärder, som dels handlar om ifall man dels algoritmiskt kan göra något åt saken, dels om man lagstiftningsvägen kan komma åt det hela, till exempel genom att på något pålitligt och obligatoriskt sätt kan markera ut vad som är skapat av en AI-algoritm. Gråzonerna blir förstås många, man har ju redan i årtionden ”förbättrat” bilder med datorer, utan ”AI”. Lagstiftning är dessutom noll värd ifall inte alla länder och territorier samtidigt inför samma lagstiftning, och tekniska åtgärder som äkthetscertifikat har historiskt visat sig vara relativt lätta att även kringgå med tekniska medel.

Problematik: den mänskliga faktorn

De nya verktygen är frestande för individen att använda då man under press ska producera något åtminstone till synes adekvat, med risk för bristande kvalitetskontroll. Vi har redan sett några skrämmande exempel i media. En minnesskrift på msn.com över en amerikansk basketspelare som dog ung kallade honom i rubriken ”Värdelös vid 42”. Men på annat håll kanske företagsledningen ändå gnuggar händerna och ser produktivitetsökningar och kostnadsinbesparingar framför ögonen: kan någon nu sägas upp?

Säkert är att den tekniska utvecklingen påverkar arbetslivet, precis som den tekniska utvecklingen gjort hittills under mänsklighetens historia. Detta helt frånsett om vi på denna utveckling sätter en AI-stämpel eller inte. En del jobb kommer med säkerhet att minska, försvinna, eller förändras i grunden. Precis som förr. Det som politiker och beslutsfattare borde fundera över är ifall utvecklingen idag är så snabb, att vi inte i samma takt hinner hitta på nya jobb och nya sysselsättningar. Som vanligt torde den kommande verkligheten ligga någonstans mellan de rosigaste scenarierna – att automatisering, ”AI” leder till att vi alla är lediga och kan förverkliga oss själva – och de värsta – en grå dystopisk framtid där endast en liten elit besitter allting och lever gott.

Framtiden – expertsystem

En trolig utveckling inom den närmaste framtiden, som även sågs under den senaste stora ”AI-boomen”, var att hyperbolen småningom förvandlas i mer praktisk riktning mot så kallade expertsystem, där tillämpningarna blir mer snäva, och handlar om de datamängder och den statistik organisationer och företag själva skapar. Med en språkmodell blir det till exempel lättare att med frågor på naturligt språk få ut intressanta resultat och svar ur all påsamlad data, i stället för att man är tvungen att koda komplicerade söktermer.

Många goda språkmodeller är redan idag öppen källkod (det vill säga gratis). För att köra sådana system behöver man inte involvera Microsoft, Google eller någon annan stor och dyr tredje part. Genom att köra modellerna lokalt har man även bättre koll på dataintegriteten och datasäkerheten gällande material som kan betraktas som egenutvecklat eller hemligstämplat.

Övervakning och personliga friheter

Myndigheter och beslutsfattare har intresserat sig för AI, eller egentligen för massiv databehandling, redan flera år innan 2022. I den frågan kan man säga att två motsägelsefulla idéer möts. Den om myndighetsövervakning av medborgarna i namn av brottsbekämpning, och den om personliga friheter. Till diskussionen fogas även idag den sortens inkräktelse på personlig integritet som både kommersiella företag och kriminella sysslar med då du rör dig på nätet.

De här motsättningarna har vi ännu inte sett spelas ut mot varandra till fullo på de tongivande lagstiftande arenorna – varken inom EU eller i USA. På båda hållen skiljer sig utgångspunkterna sig dessutom något. Generellt kan man säga att USA är mer tillåtande till kommersiell ”övervakning”, medan EU-parlamentet varit striktare – med GDPR som exempel – och där man nu förbereder lagpaket som till exempel ska begränsa eller förhindra den sortens automatiserade beslutsfattande som ofta stereotypiserar människor med etniska eller kulturella bakgrunder som avviker från huvudfårorna. Samtidigt pågår en hård polisiär och politisk lobbyverksamhet både i EU och i USA, som i namn av borttsbekämpning vill luckra upp till exempel den kryptering som medborgarna har tillgång till för att skydda sina meddelanden och sin kommunikation. Många av dessa lobbyister verkar tyvärr ha skrala tekniska och filosofiska kunskaper i ämnet. När det gäller kryptering har ju hästarna för länge sedan rymt från boxen, så gör man kryptering brottsligt, är det till sist bara brottslingar som krypterar sina meddelanden.

När det gäller lagar och förordningar får man alltså hoppas på att politiker, beslutsfattare och myndigheter skapar tillräckligt allmängiltig lagstiftning och tillräckligt allmängiltiga regler, som inte tar ställning till och lagstiftar kring specifika tekniska lösningar, som dagens chatbotar eller enskilda tjänster som TikTok. Sådant blir nämligen fort gammalt, och dessutom oftast fullt med kryphål. Likaså får man hoppas att lagstiftarna främst håller den individuella medborgarens intresse för ögonen.